AI治理的国际实践观察

新闻资讯

xxxxxxxxx

编者按

AI技术的快速发展对治理者提出了前所未有的挑战:他们需要及时地了解技术本身和技术带来的影响,并在适当的时机,并在不过度影响创新和发展的前提下,采取合适的治理措施。

关于AI治理,本公众号已发布的文章有:

AI治理面临的挑战

挑战1:速度(speed)

自2022年11月ChatGPT 3 发布以来,全球已然掀起了一场关于AI的竞赛。这场竞赛中,技术发展和应用的速度之快已远远超过以往任一项技术,这对治理者理解技术的能力带来了前所未有的挑战。

挑战2:自动化(automony)

基于算法做出行动和决策的AI是自动化的,自动化的AI将为一些传统的受监管行为带来新的威胁。以网络诈骗为例,借助AI,整个诈骗过程(从诈骗对象的选择到编辑创建诈骗信息)可以实现自动化。

美国联邦贸易委员会(FTC)在关于人工智能语音诈骗咨询中的举例:

诈骗者可以将其从在线社交网站中获取的仅有3秒的音频片段输入人工智能模型,以伪造来自诈骗对象亲友的语音信息。人工智能模型还能够与目标进行对话:

挑战3:黑匣子(opacity)

人工智能治理的第三个挑战是算法的“黑匣子”:即使是人工智能的开发者自身也常常无法准确地指导AI是如何做出最终的决策的。AI的黑匣子属性对既有监管方式中的法律责任的分配和透明度等都带来了挑战。

AI治理的实践

如既往的其他新兴技术出现时一样,AI的监管面临着困境:

在能够控制的发展早期,无法预知监管对限制发展会产生多少负面效应;在负面效应可知之时,监管可能需要花费极大成本且效用缓慢。

因此,在做出监管行为之前,需要首先判断是否有监管的必要性,比如是否有解决市场失灵的必要?是否需要通过AI监管支持其他社会政策的落实?;此外,还需考虑是否能够避免/减少监管对创新产生不利限制或导致竞争优势丧失?

--欧盟的做法

在AI监管方面,走在前面的欧盟为我们提供了一条“基于风险的路径”(risk-based approach)——对AI进行多层次的、基于效果的分析,采取分层的监管方式:根据可能带来风险水平的评估,执行不同的措施。比如,进行垃圾邮件过滤的人工智能工具与可能威胁个人人身安全的人工智能技术采取的监管措施将完全不同。

无论如何,AI的本质是一种数字系统。而纵观技术发展的历程,数字系统发展和管理的核心是技术标准:这些技术标准与产业实践相协同,并旨在预测和降低技术发展过程中的困难(比如手机标准从1G到5G的演变)。

从这个角度出发,AI的治理就不一定必须通过硬法(hard law)进行:国家/政府立法仅是对AI进行治理的维度之一,除此之外,AI开发者(产业界)的最佳实践、标准和自我监管以及国际产业合作(比如国际电信联盟ITU的模式)也是AI治理的重要层面。

硬法(hard law)是指那些能够依靠国家强制力保证实施的法规范,比如国家颁布的宪法和刑法。软法(soft law)是指那些不能用国家强制力保证实施的法规范,比如政治组织创制的自律规范和社会共同体创制的自治规范。

--新加坡的做法

新加坡正在走上与欧盟不太相同的AI治理路线。新加坡政府认为,监管部门还需要在了解AI在技术方面如何运作,以及开发适用合适的监管工具方面做很多工作,现在对AI进行监管和执法还为时过早。

在以上思想认识的指导下,新加坡信息通信媒体发展局(IMDA)成立了AI Verify基金会(AI Verify Foundation),以利用全球开源社区的集体力量和贡献来开发AI Verify测试工具,以负责任地使用AI。

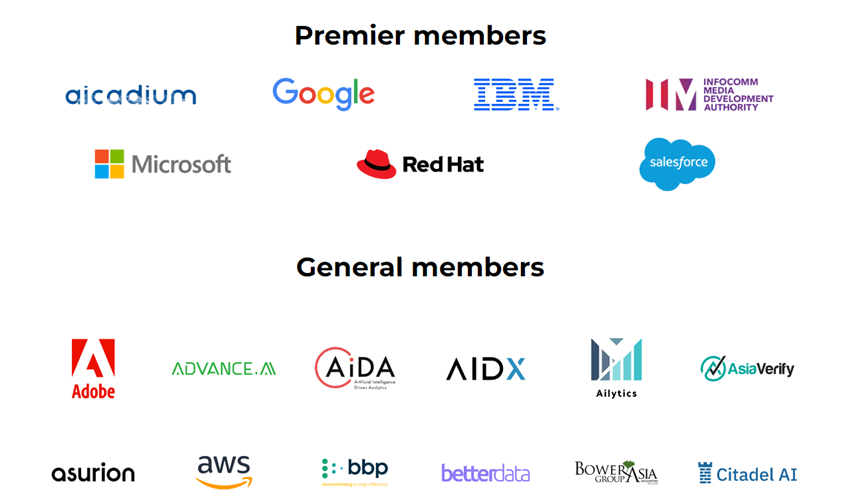

AI Verify Foundation拥有七个主要成员,即Aicadium,Google,IBM,IMDA,Microsoft,Red Hat和Salesforce,他们将制定AI Verify的战略方向和发展路线图。基金会还有60多名普通会员。

图:AI Verify基金会的部分会员

AI Verify基金会目前正在开发一个AI 治理测试框架和软件工具包,该测试框架由11项人工智能道德原则组成,这些道德原则整合自欧盟、经合组织和新加坡等国际工人的 AI 治理原则框架,包括透明度、可解释性、可重复性/再现性、安全性、稳健性、公平性、数据治理、问责制、人类机构和监督、包容性增长、社会和环境福祉。

AI 验证工具包的测试过程包括技术测试和过程检查。工具包可以在用户企业环境中运行,帮助用户对其人工智能模型进行技术测试并记录流程检查。之后,该工具包会为正在测试的人工智能模型生成测试报告。

目前,这个工具包的开发在Github上开源进行开发:

AI治理的挑战与实践是一个复杂而重要的议题。欧盟和新加坡的努力都是为了确保AI的发展和应用能够符合透明度、安全性、公平性等重要原则。AI治理的道路还很漫长,但通过国际合作和技术标准的制定,我们有望找到合适的方法来解决AI治理的挑战,推动AI的可持续发展。

参考文献

[1]https://consumer.ftc.gov/consumer-alerts/2023/03/scammers-use-ai-enhance-their-family-emergency-schemes

[2]https://www.brookings.edu/articles/the-three-challenges-of-ai-regulation/

[3]https://aiverifyfoundation.sg/foundation-members/

[4]GitHub - IMDA-BTG/aiverify:AI Verify